Специалисты Recorded Future рассказали, как ИИ будет использоваться в атаках нового уровня , сообщает securitylab.ru .

Фото: freepik.com

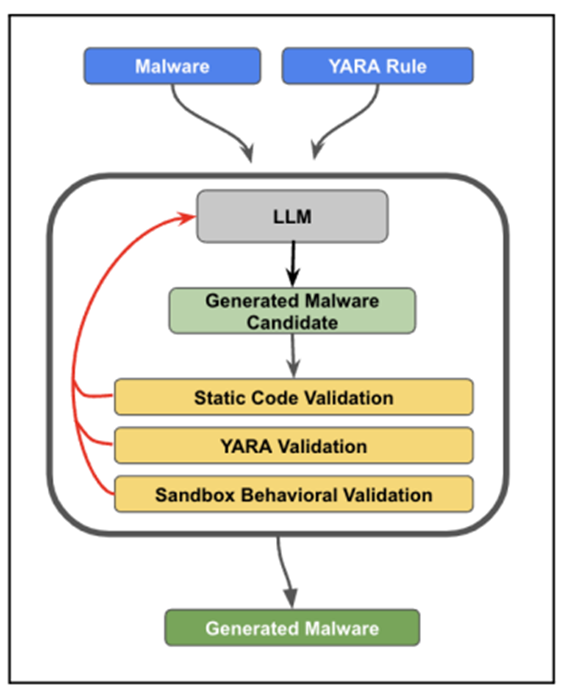

В новом отчете компании Recorded Future, посвященном безопасности информационных технологий, описывается, как большие языковые модели (LLM) могут использоваться для создания самосовершенствующегося вредоносного ПО, способного обходить правила YARA.

Эксперименты показали, что генеративный ИИ может эффективно изменять исходный код вредоносных программ для уклонения от обнаружения на основе правил YARA, тем самым снижая вероятность их обнаружения. Такой подход уже исследуется киберпреступниками для генерации фрагментов вредоносного кода, создания фишинговых писем и проведения разведки потенциальных целей.

В качестве примера компания обратилась к LLM с запросом на модификацию исходного кода известного вредоносного ПО STEELHOOK, чтобы обойти обнаружение без потери функциональности и ошибок в синтаксисе. Полученное таким образом измененное вредоносное ПО смогло избежать обнаружения по простым правилам YARA.

Тем не менее, существуют ограничения на такой подход правил, связанные с объемом текста, который модель может обрабатывать за один раз, что затрудняет работу с большими кодовыми базами. Однако, как утверждает Recorded Future, киберпреступники могут обойти это ограничение, загружая файлы в инструменты LLM.

Цепочка создания вредоносного ПО с помощью LLM для обхода YARA

Исследование также показывает, что в 2024 году наиболее вероятное злонамеренное использование ИИ будет связано с дипфейками и операциями влияния:

- Дипфейки, созданные с использованием open source инструментов, могут использоваться для имитации личностей руководителей, а генерируемые ИИ аудио и видео могут усилить кампании социальной инженерии.

- Стоимость создания контента для операций влияния существенно снизится, что упростит клонирование веб-сайтов или создание поддельных СМИ. ИИ также может помочь разработчикам вредоносного ПО в обходе обнаружения, а злоумышленникам – в разведывательной деятельности, например, в определении уязвимых промышленных систем или поиске чувствительных объектов.

Кроме модификации вредоносного ПО, ИИ могут использоваться для создания дипфейков высокопоставленных лиц и проведения операций по влиянию, имитируя легитимные веб-сайты. Ожидается, что генеративный ИИ ускорит способность злоумышленников проводить разведку объектов критической инфраструктуры и получать информацию, которая может быть использована в последующих атаках.

Организациям рекомендуется готовиться к таким угрозам, рассматривая голоса и внешность своих руководителей, веб-сайты и брендинг, а также публичные изображения в качестве части их атакуемой поверхности. Также следует ожидать более сложного использования ИИ для создания вредоносного ПО, которое уклоняется от обнаружения.

Источник securitylab.ru